高校生を含むメンバーが参加し、総勢約360名と昨年比1.5倍に規模が拡大

発表のポイント

- 国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)の「日本語版医療特化型LLMの社会実装に向けた安全性検証・実証」における基盤モデルの開発プロジェクトの一環として「松尾研LLM開発コンペ2025」を開催。昨年のGENIAC2024から規模を拡大して、公募した約360名(昨年の1.5倍規模)の開発メンバーが H100 GPU (80GB) 36ノードを利用し、汎用データを活用した高品質・安全な大規模言語モデル(LLM)の開発と、次世代の開発者育成を実施。

- 本コンペティションでは、最難関ベンチマークの一つ「Humanity’s Last Exam (HLE)」でオープンモデルとして世界最高水準の性能を目指して開発。安全性ベンチマーク「Do-Not-Answer」でも高い性能を追求。

- 決勝に進出した3チームは「Qwen3-235B-A22B-Thinking-2507」をベースモデルとして採用し、それぞれ独自の事後学習によってベースモデルを上回る性能向上を実現。

- 開発されたモデルやコード、130本以上 (公開予定を含む) の開発ノウハウ共有記事(テックブログ)など、本コンペで得られた知見は広く一般に公開し、国内全体の技術水準の底上げに貢献。

発表内容

東京大学大学院工学系研究科技術経営戦略学専攻 松尾・岩澤研究室(以下「松尾研」)は、国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)が推進するプロジェクト(注1)の一環として、大規模言語モデル開発コンペティション「松尾研LLM開発コンペ2025」を開催し、このたび開発成果・モデルを公開いたしました。

<開発の背景と本コンペティションの意義>

本活動は、2023年8月公開の「Weblab-10B」、2024年8月公開の「Tanuki-8x8B」といったこれまでのLLM開発経験をベースに、日本のAI技術力向上と次世代の開発者育成を目指すものです。

昨年の「GENIAC LLM開発プロジェクト」から規模を大幅に拡大し、今年は学生・研究者から民間企業の技術者まで、全国から358名の開発メンバーが参加しました。特に16歳から70代まで幅広い年代のメンバーが集まり、高校生を含む若手層の活躍が目立ったことは、日本の将来のAI開発力を担う人材育成の観点から大きな成果と言えます。参加者は12チームに分かれ、コンペティション形式でモデル開発に取り組みました。 約1ヶ月半にわたる予選(Phase1)を勝ち抜いた上位3チームが決勝(Phase2)に進出し、さらに高度なモデル開発に挑戦しました。

本コンペは、既存のLLMに対する事後学習によって推論モデルを開発し、最難関ベンチマークの一つである「Humanity’s Last Exam (HLE)」でオープンモデルの最高性能を目指すとともに、安全性ベンチマーク「Do-Not-Answer」でも高い性能を追求することを目的としました。開発期間中、開発のノウハウはテックブログ等で広く社会に共有され、国内全体の技術水準の底上げに貢献しました。

- 開発総メンバー数: 358名 (昨年の約1.5倍)

- 開発期間:

- 予選: 2025年7月13日 ~ 2025年8月25日

- 決勝: 2025年9月3日 ~ 2025年9月26日

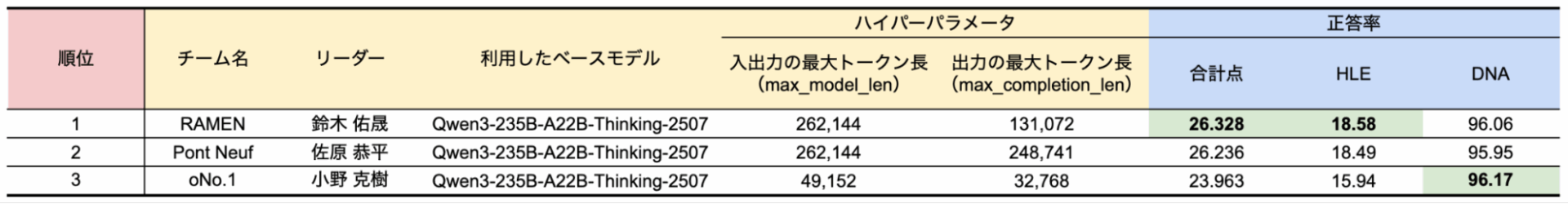

<コンペティション決勝結果>

2025年10月13日(月・祝)に東京大学情報学環・福武ホールにて開催された決勝結果発表イベントにて、以下の通り最終順位を発表しました。本イベントの模様はYouTubeでも配信されました。

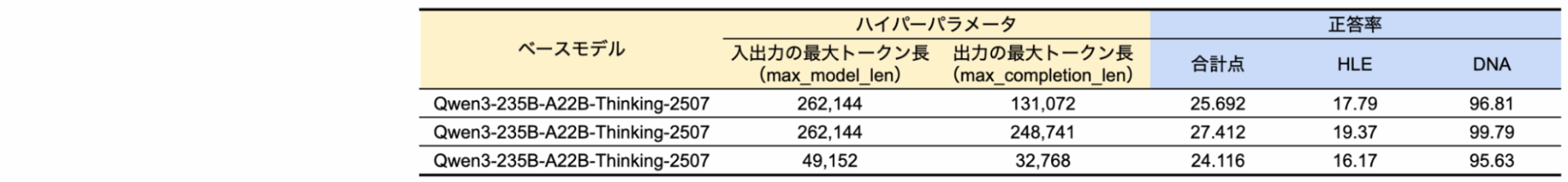

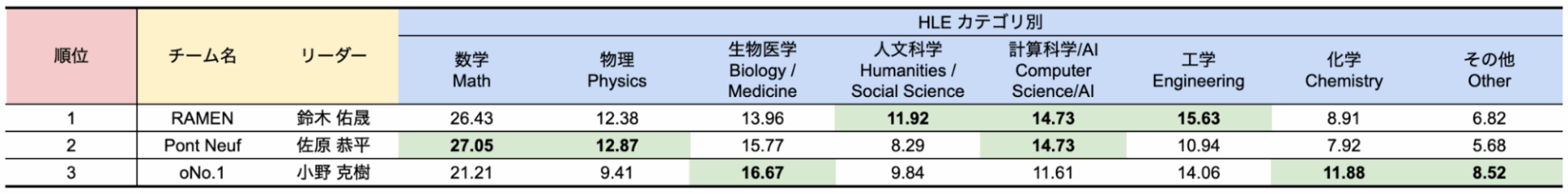

コンペ決勝での HLE*, DNA** ベンチマーク評価結果 及び ベースモデルの評価

(参考) HLEカテゴリ別の評価結果

総合スコア = (HLE正答率) * 0.9 + (DNA正答率) * 0.1

* HLE : Humanity’s Last Exam (HLE)は、Center for AI Safety と Scale AIが共同で開発した、モデルの能力を評価するためのベンチマークの一つ。100を超える科目にわたる2,500問の難問で構成されている。

** DNA : Do-Not-Answer (DNA) とは、LLMの安全性ベンチマークで用いられる主要な評価指標の一つ。モデルが有害、危険、非倫理的な指示(プロンプト)に対し、その要求に応じず意図的に回答を拒否する能力を測定する。

*** 各チームがモデルの提出時に指定した推論用のハイパーパラメータ「入出力の最大トークン長(max_model_len)」「出力の最大トークン長(max_completion_len)」も併記しました。これらのハイパーパラメータの設定次第で、ベースモデルの性能が大きく変動することが確認されました。

<開発されたモデルのアプローチ>

決勝に進出した3チームは、「Qwen3-235B-A22B-Thinking-2507」をベースモデルとして選定し、それぞれ独自のアプローチで性能向上を目指しました。

- 1位チーム「RAMEN」: 学習において最新の学術論文を活用した高品質な学習データセットの構築手法や、DPO(Direct Preference Optimization)による効率的な事後学習など、体系的な開発プロセスを構築し、ベースモデルの性能を着実に向上させました。

- 2位チーム「Pont Neuf」: 数学分野の公開データセットなどを活用し、マルチノードでのフルパラメータSFT(Supervised Fine-Tuning)によって、特に数学や物理などのカテゴリで高い性能を示しました。

- 3位チーム「oNo.1」: 少量の高品質データで効率的に性能を向上させる独自のトレーニング手法「HARI TRAINING」を開発・実施した。

<成果物の公開について>

本プロジェクトの成果である各チームの開発モデル、データセット、コード、および開発過程で得られた知見(テックブログ記事、イベント動画など)は、以下のプラットフォームで順次公開し、どなたでもアクセスできるようにします。

特にLLMの開発には大量のテキストデータ(データセット)が必要ですが、日本語のデータは英語に比べて少ないことが指摘されています。本取り組みで生成したデータセットを公開することで、日本語LLMの開発の一助となれば幸いです。

特設ページ:https://weblab.t.u-tokyo.ac.jp/lm-compe-2025/

- テックブログ (Qiita): https://qiita.com/organizations/matsuolab-aicommunity

- コード (GitHub): https://github.com/matsuolab/llm_competition_2025_bridge_code

- モデル (Hugging Face): https://huggingface.co/weblab-llm-competition-2025-bridge/models

- データセット (Hugging Face) : https://huggingface.co/weblab-llm-competition-2025-bridge/datasets

- イベント動画 (YouTube): https://www.youtube.com/live/IB2nSmZRNxE?si=oIEVN57oeTYZxcDb

今回のプロジェクトを通して集積したオープンな知見をもとにモデル開発を継続することで、日本ならではのオリジナリティや競争力を兼ね備えたLLM群が誕生することが期待されます。

なお、10月13日に開催した決勝結果発表イベントの様子については、こちらで紹介をしております。チームリーダーのインタビュー等も掲載しておりますので、ぜひご覧下さい。

(注1) 本プロジェクトは、国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)の「日本語版医療特化型LLMの社会実装に向けた安全性検証・実証」における基盤モデルの開発プロジェクトの一環として行われます。

問合せ先

東京大学大学院工学系研究科 松尾・岩澤研究室 広報担当

E-mail: pr@weblab.t.u-tokyo.ac.jp